企业大数据治理的六条军规

-

史凯

-

2018-05-21

引子

凯哥在过去做过众多大型数据类项目,有数据规划咨询、数据治理、数据仓库实施、数据可视化等类别。使用过市场上大部分的数据平台和工具,比如Cognos/BIEE/MicroStrategy/Teradata/Tableau/Pentaho/SAPBW等。

但是虽然那时候也都说是企业级数据仓库,但是由于计算能力和存储能力的限制,其实实施的数据仓库大部分都是部门级的,是面向某一个业务领域或者面向一个业务问题的,并非企业级的,所以做到后来基本上每个企业都有多个数据仓库的实体,缺乏企业级的统一数据治理模型。

云计算提高了计算能力,分布式存储的发展提高了数据存储的能力,这个时候,企业大数据之旅才刚刚开始。

数据是资产,是企业的核心价值,这个观点已经被所有的企业所接受,所以现在各地的大数据交易所层出不穷。但是企业的大数据应该如何利用,如何管理,有哪些基础的规则和原则,这是大数据能力建设的理论支撑和保障。

这里凯哥基于过去的经验以及近期的思考,总结以下的企业大数据治理的六条军规,供大家参考。

这是第一版,欢迎大家热烈的拍砖,评论。

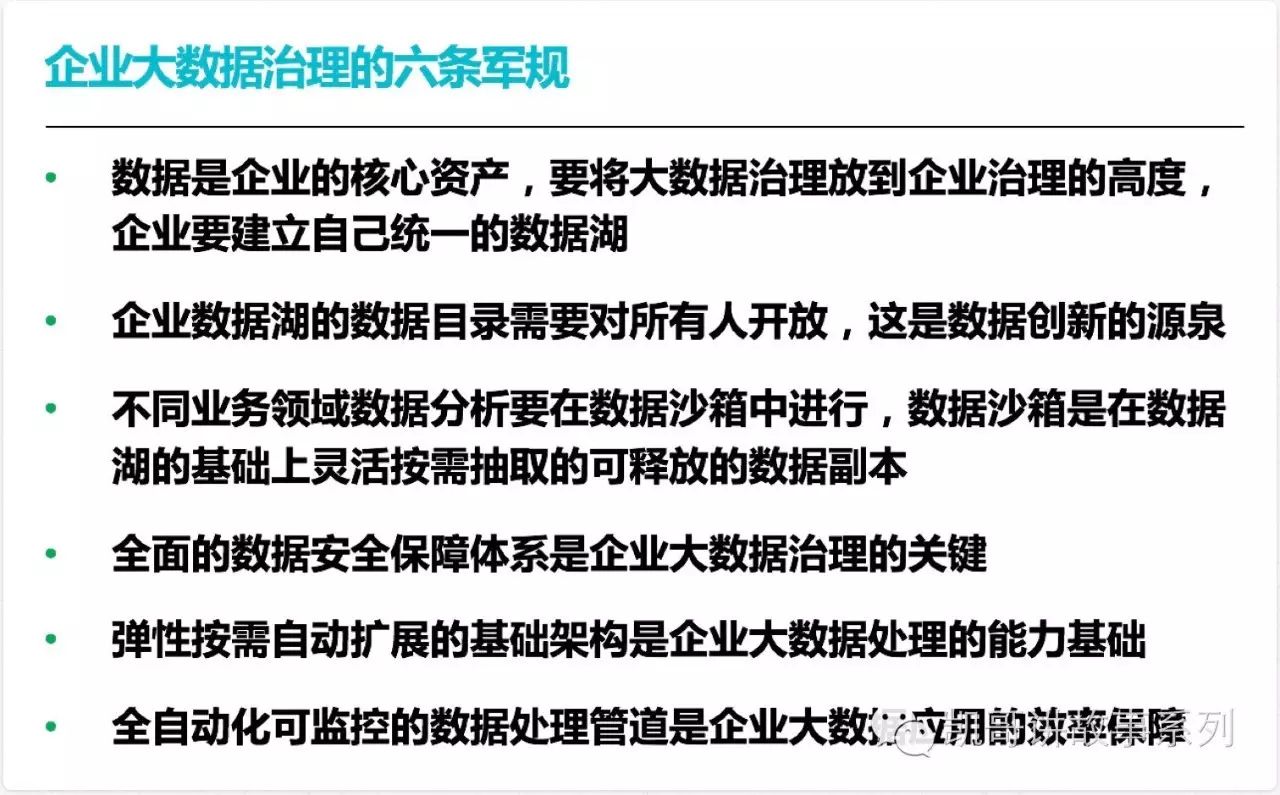

企业大数据治理的六条军规

成为军规的条件是:

1. 站在企业级的高度层面

2. 站在大数据治理的原则层面

第一条军规

数据是企业的核心资产,要将大数据治理放到企业治理的高度,企业要建立自己统一的数据湖

所有系统产生的数据都是有价值的,即使现在你利用不上,那是因为技术和业务的能力还不够

企业大数据治理和企业的人力管理、财务管理、设备管理(人、财、物)是一样重要的

统一的数据湖不意味着是必须集中部署的数据湖

原来的数据是各部门根据自己的局部业务目标理解存储的,现在起要将数据从部门高度提高到企业高度,统一做顶层设计和管理

过去很多企业实施的数据仓库是由于计算能力和存储能力的限制,其实大部分都是部门级的,是面向某一个业务领域或者面向一个业务问题的,并非企业级的,所以做到后来基本上每个企业都有多个数据仓库的实体,缺乏企业级的统一数据治理模型。

数据湖是面向企业架构的,将所有源数据(RAW Data)统一管理,分布式存储的数据存储

数据湖是异构存储的,不要求统一的数据存储格式和技术架构。

第二条军规

企业数据湖的数据目录要对所有人开放,这是企业数据创新的源泉

没有数据目录的数据湖,就像没有目录和索引的图书馆

这里的数据目录就是meta data,它记录和管理者数据湖里存储的所有的数据的格式、业务含义、存储地址、访问方式、更新频率、权限级别、使用限制等信息,能够指导数据的使用对象如何利用这些数据。

企业的数据目录要是统一管理,统一更新

企业的数据目录一定是统一管理和统一更新的,只有这样才能保证数据目录的实时性、可用性,所以数据目录是一个独立的服务,它应该独立于数据湖之外

企业的数据目录要对所有人开放

从推动创新和信息透明的角度,数据目录要对企业所有人开放,让企业所有人都可以知道本企业有哪些数据,这些数据都有什么业务意义。

这是企业数据创新的基础,没有这个做基础,企业的创新要么就是没法落地的空想,要么就无法激起员工的创新灵感。

企业的数据目录要起到隔离真实数据敏感信息的安全保障作用

这里的开放是有条件的开放,数据目录要通过技术和管理手段隔绝真是数据敏感信息的安全保障作用。就是说要让大家都知道企业有哪些数据,都有什么价值,但是具体数据是什么,存在哪里,如何方案,这些信息要在有了数据权限后才能开放。

第三条军规

不同业务领域数据分析要在数据沙箱中进行,数据沙箱是在数据湖基础上灵活按需抽取的可释放的数据副本

数据湖的数据是企业的永久数据存储中心,一般来说是只读的

从性能和安全角度,要根据不同的业务目标建立不同的数据沙箱(Sandbox),然后在数据沙箱里做数据分析,按需使用和销毁

第四条军规

全面的数据安全保障体系是企业大数据治理的关键

全面的数据安全保障体系是大数据治理的关键,这里的数据安全保障体系,包括权限、身份认证、数据加密、传输安全等层面。

数据湖建立的同时就要考虑安全体系的建设,这个和数据存储的方式、访问方式、访问流程、利用流程是息息相关的

要根据数据的业务价值的不同,对数据进行安全级别的区分,从而执行不同的安全标准行动

第五条军规

弹性按需自动扩展的基础架构是企业大数据处理的能力基础

企业的数据是动态不断增加和变化的,这需要企业具备弹性按需自动扩展的基础架构(云计算能力),才能横向扩展,保障数据资产的高可用性

数据湖的存储,根据数据结构的不同,数据更新频率的不同是分布异构存储和处理的,这对于动态计算资源的要求很高

第六条军规

全自动可监控的数据处理管道是企业大数据应用的效率保障

数据的处理管道(data process pipeline)要求是全自动的。从数据的采集、存储、加工、建模、变成应用服务(Microservice),都需要是全自动的,这样能够保障企业大数据应用的效率。

所以,大数据的处理管道能力是需要CI/CD/DevOps的支持的。

数据整个的处理过程,需要可监控,企业能够随时了解和监控数据的CRUD的过程,做到数据的可审计性

总结

企业的大数据治理的六条军规,简化就是下图

这正好和企业架构也是异曲同工的,这幅图更好记,每个企业在构建自己的大数据能力的时候,都要按照这个架构来设计,才能保证数据价值的充分发挥和数据的安全。

这是一个粗的总结,后续凯哥会针对每一块的内容详细阐述,如何构建企业的大数据能力,请关注凯哥讲故事。

关注凯哥讲故事,获得原创的科技洞见和人生感悟。

文章转载自微信公众号「 凯哥讲故事系列 陈庆」

- 案例

- 农业

- 采矿

- 制造

- 食品饮料

- 烟草

- 鞋服纺织

- 家居家具

- 化工

- 钢铁

- 机械装备

- 汽车

- 能源化工

- 建筑

- 批发零售

- 交通物流

- 住宿餐饮

- IT/互联网

- 通信

- 软件信息

推荐

我要评论