李飞飞谈AI医疗:为什么我要从监督医生洗手开始做起?

智能产业头条

2018-07-04

作为 AI 界的领军人物,谷歌云人工智能和机器学习首席科学家李飞飞一直致力于 AI 民主化,希望利用 AI 造福社会。在近日举行的清华大学—谷歌 AI 学术研讨会上,李飞飞就介绍了自己在“AI + 医疗”领域的最新前沿工作。

和机器阅片等常见的 AI 医疗应用不同,李飞飞希望通过计算机视觉技术分析医务人员的行为,然后给出反馈,帮助他们为病患提供更高质量的医疗服务,当然这里面目前还存在诸多的困难和挑战。

李飞飞表示,这项研究的第一个落地应用就是监督医护人员清洗双手,这是为什么?

以下为演讲实录:

感谢清华大学的邀请!作为谷歌AI中国的团队,我们也很荣幸有机会在今、明两天与大家共同探讨基础科学的学术话题。

今天我给大家分享的实际上是最近五六年以来一次比较新的探索,虽然大家知道我做的很多研究很多都是计算机领域机器学习的基础科学,但是在应用方面,我们一直坚信“以人为本”的AI,需要对人类的福祉有所帮助。我个人最重视的一个应用领域是医疗健康领域,所以,此次讲座我将给大家分享一下,最近两年我们在医疗健康领域的一些探索,还希望听取大家的意见。

这次演讲的主题是 Illuminating the Dark Space: Towards Ambient Intelligence in AI-assisted Healthcare。

▌何为Ambient Intelligence?

在中国和美国,医疗健康都是最受关注的问题。不断提高的成本,是全球医疗健康的主要问题之一。虽然医疗成本不断上涨,但质量并不见得会一定提高。那我们又该如何提高医疗质量呢?削减成本是目前主要的研究和提高的方向。但幸运的是,在过去的十年里,推进医疗方面的工作已取得了很大的成就。我们已经看到药物和疫苗上的改进。我们看到了医疗影像的改进,医疗设备等方面巨大的进步。正如我的同事 Jeff Dean 在上午的分享中提到的那样,大数据和人工智能正推动医疗健康特别是诊断方面的进一步发展。此外,精密医学、药物发现相关的治疗选择,正基于机器学习、人工智能取得了新的进展。

但是,在过去几年里我关注的医疗健康领域里,有一个往往被多数人忽略的领域,即医疗健康服务的物理空间。如果你考虑到了“医疗”这个词,那么“疗”这个词则非常重要。因为,物理空间指的是临床医生、护士、医生为治疗病人的地方。我们需要在一定的物理环境下通过与患者的互动来提升医疗服务的水准。

因此,在这段时间里我们在斯坦福大学研究的方向是,赋予医疗物理空间“Ambient Intelligence”的属性。让我先来定义下“Ambient Intelligence”的概念。需要说明的是,我们并非第一个想到这个概念,而这个概念也并非特属于医疗领域。因此,一个可接受的定义是:未来将是一个环境满足需求的世界,多数情况下我们无需思考,智能也会萦绕空间,就像这个房间里的灯光。你感受不到科技的存在,但它就在那里,帮助我们更好地做一些事情。这就是我们所说的“Ambient Intelligence”。

那么,为什么我们需要变得智能?为什么我们需要提高医疗健康的服务质量?这是因为,执行和操作是临床医生在医疗服务中的一大痛点。在医疗领域,我们通过数百年知识的积累,需要在各种程序中完成预期的操作,而实际上,符合预期的操作并不总是发生。当出现小毛病、疏忽或错误时,就会涉及医疗成本。而这种成本,往往关乎人类的生命。

事实上,如果与一年内车祸死亡的人数相比的话,医疗事故引发的死亡人数远远高于前者。所以,这对我们而言是一个非常重要的问题。如果 AI 可以用来帮助解决这个问题,那么这会是一个以人为本的应用。在美国,国家医学研究所每隔几年就会针对医疗服务中出现的人为错误进行深度研究。这是我们思考的起点。

为什么临床医生会在医疗中犯错误呢?这一切都是靠人的主观意识完成的。在一个高度复杂的环境下,治疗到什么样的程度也是非常复杂,中间有很多步骤和程序,也有很多的不确定性和不可预测性。

而且,错误或疏忽等都会导致这些问题的发生。所以,当潜在的错误都可以预测时, 便意味着以上医疗问题都能得以解决。例如,病人可能会从床上掉下来,就需要通过行为活动传感器以检查患者是否坠落。再或者检查是否需要进行手部卫生的处理,与之相关的传感器就被发明出来,试图解决这个问题。此外,还有许多不同类型的本地化解决方案试图缩小医疗健康质量与服务之间的差距。

这关键就在于高度本地化。 每当出现一个错误或潜在的缺陷,就需要一个新的解决方案,且不具备可扩展性。这些本地化解决方案有很多不同的情景无法预测、监控。

那么我们能做些什么呢?

有另一种方式可以考虑改善医疗健康的质量。大概五年前,我和斯坦福的同事们就开始跟进一种新的技术浪潮——自动驾驶技术,而这种新技术似乎与医疗健康毫无关系。但事实上,它们是高度相关的。

先来看看自动驾驶汽车是如何工作的。

这是一款配备了智能传感器的汽车,它能够感知从行人,到汽车、物体、路标等的道路环境。而且,一旦它能感知环境,就会将信息输入到后台,你就能利用机器学习算法做出决定和预测,辅助汽车驾驶。所以,我们受到这种思维以及“Ambient Intelligence”概念的启发,想要将 AI 注入到医疗服务的物理空间中,以便我们能够协助执行预期的步骤。

这是一个医院单元的示意图:由许多传感器覆盖,可以观察不同的医疗服务情况。首先,我们需要通过传感器的性能来改造物理空间,如果是一家(设备)传统的医院,它可能就没有现代化的传感器以帮助收集并将这些潜在的信息传递给算法。接下来,一旦我们收集了数据,我们需要辨认出在这个环境里的活动,无论是手术室、病人康复室,还是在养老院里。

而辨认出该医疗活动的关键因素在于对人类活动的理解进行可视化。现在,如果你来自计算机视觉领域,那么你可以将医疗应用与计算机视觉的基础科学联系起来。事实上,多年以来,理解人类活动一直是计算机视觉的核心问题。所以,我将展示一些可以帮医疗服务环境提升的基础科学研究。最终我们希望整个医疗数据可以整合到整个医疗生态体系中。

▌让AI注入医疗服务的每一环节

接下来的演讲中,通过展示我们最近的一些工作,我将分享到以下三个研究方向:感知、人类活动识别,以及医疗生态体系。

1、感知

首先是感知,即将传感器集成到物理空间,并构建一个数据基础架构的过程。我们最近在《新英格兰医学杂志》上发表了一篇评论文,讨论了我们在试点中所做的工作。

我想问在座的各位:在医疗服务环境中,基于“Ambient Intelligence”的感应系统最重要的部分是什么?

一是隐私,这是非常重要的。患者需要隐私,临床医生也需要隐私。

二是通过空间进行感知。刚才提到的本地化解决方案,其部分问题是因为太过于本地化了,很难在空间上扩展。

三是根据时间进行感知。如果人类来观测活动,他们往往会感到厌倦。

所以,我们想利用机器并且将其变得可扩展。在过去的数十年里,现代传感器已经有了很大的发展。那些曾经玩过 Xbox 视频游戏的玩家,应该都知道深度传感器,它可以用来保护隐私。

如何通过深度传感器收集人类活动的数据?

在我们的两所试点医院(犹他州儿童医院和承认重症监护病房)中,我们进行了深度传感器的试用。(图片上)能看到橙色的圆点就是深度传感器,它们被安装在医院的病房中。例如,在儿童医院,我们安装了将近30个不同的传感器,目的就是为了通过传感器获取更多的数据以理解人类的行为。

还有一种传感器,它与前者相互补,主要作用于生理信息,即热传感器。通过深度传感器可以看到病人轮廓;而通过热传感器收集信息,你不仅可以看到病人的轮廓,你实际上还能看到其他关键的物体,如氧气管。这对病人而言是非常重要的。所以,在我们的试点研究中,我们同样也会用到热传感器。

实际上,我们正在与旧金山的一所养老院合作,在养老院里安装了热传感器和深度传感器,以帮助医生监测老人的行为,帮助他们独立生活。

其实,将传感器投放在医疗环境中,数据基础架构的建设就已经面临着巨大挑战。例如,持续的数据源就意味着大量数据的涌入。如果我们使用传感器的原始分辨率,就会出现需要处理海量数据的问题。因此,我们进行了一些自适应抽样以减少要处理的数据。

这些都是我们必须面临着的技术挑战。但我们依然保持着:对人类行为识别的计算机视觉研究的专注,也希望应对医疗环境下的种种挑战,为计算机视觉的基础科学研究做出贡献。

2、人类活动识别

视觉智能,指的是在动态物理世界中发生的过程。谈到动态这个概念,有很多的信息、事物转瞬即逝。这意味着:我们有时会处理之前从未见过的情况。例如,在医疗环境这种复杂的情况下,这名患者在地板上睡了会儿,在床上又睡了会儿。这并非是我们通常利用数据进行训练的场景。所以,这种问题有待解决。

在医疗场景中,我们还要处理物理空间的限制问题。比如一般计算机视觉处理的都是类似 YouTube 用户上传的视频,但是医院的空间有限,因此传感器的装设位置也受到限制,拍摄到的都是各种角度的画面,非常具有挑战性。同样重要的是,我们还会面临计算效率的问题,因为我们希望为临床医师提供实时反馈,因此计算效率极为重要。

人类活动识别是目前计算机视觉领域最受关注的方向之一,目前也已经一些公开的数据集,而且也有很多非常不错的工作。我想介绍的是,我们是如何把我们的工作和医疗健康应用相结合的。

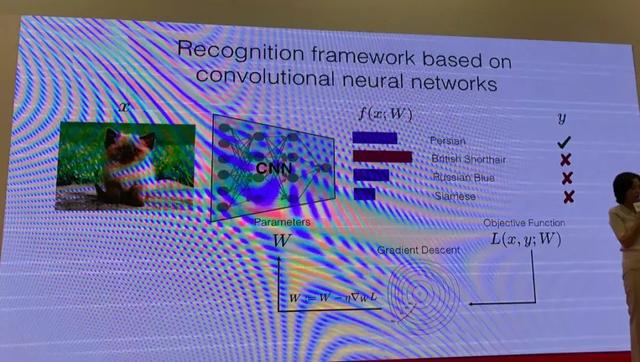

第一个是发表在 ECCV 16 上的一篇论文,论述了如何处理不同视野角度的问题,这只是最基础的。我们用到了很多深度学习结构,比如这个用来做图像分类的 Vanilla CNN 网络。

比如,我们希望检测临床医师在进出病人的房间前后是否都有洗手,就需要面临很多的挑战。首先,由于我们的传感器大都安在天花板上,因此画面的视角和正常的 YouTube 视频画面的视角非常不一样。此外,人是运动的,因此我们安装了很多传感器,来对人进行追踪。

我这里简单介绍下视角问题。我们使用了 Vanilla CNN 网络来做分类,唯一的变化就是我们增加了一个转换网络(transformer network),来解决训练数据的视角问题。然后,为了解决多个传感器的追踪问题,我们将不同的个体进行 ground projection,然后将整个 3D 空间的投影结合起来,进行联合优化,以此来追踪不同的个体。

为什么我们会选择手部卫生作为第一个应用案例呢?因为不注意手部卫生是病人死亡的重要元凶之一。实际上,因为每年死于医院获得性感染的病人是交通事故致死人数的三倍。而大多数的医院获得性感染都是没有注意手部卫生导致的。这是医疗系统里的一个顽疾,解决这个问题的唯一办法是派人到医院里监督医生和护士,督促他们洗手。但是这种方法非常低效,不仅不能做到实施监督,也非常耗费时间,而且人也可能会犯错误。

因此,通过使用深度学习和智能传感器系统来对医务人员进行追踪,我们取得了非常好的结果。和人类检查员相比,我们的方法观察到与事实更接近。

我们的系统可以追踪医务人员的行动轨迹,而这些数据对医疗系统来说非常宝贵,不仅仅可以用来追踪医务人员洗手了没,还可以用来优化工作流程。

结合智能传感器和计算机视觉识别系统,我们在手部卫生检测领域取得了鼓舞人心的结果。下一步,我们将会把反馈信号实时传递到周遭环境中,以此来督促大家洗手。不过,这还远远不够,我们还需要理解各种不同的行为,观察它们,最终帮助医生和护士优化治疗和护理流程,这一点很重要。这就引出了我们的下一项工作:密集多标签活动识别。

比如,在 ICU 里面经常会涉及到测血压、绑止血带、用医用究竟喷雾消毒等等一系列的动作,我们希望最终能够映射所有的医疗活动,帮助医生和护士更好地照顾病人。为了做到这一点,仅仅用 CNN 是不够的,特别是对于静态帧分类。我们真正想做的,是将其扩展到时域,利用视频数据来识别人类活动。很多人都对此领域做出过相关贡献,这里我就不展开了。

但是总的来说,利用视频来进行活动识别的工作仍然很少,大部分工作都是活动分类,比如为潜水视频打一个单一的标签,或者是活动检测,为视频中不同活动分配相应的标签。不过,时域理解仍然处在比较初始的水平,比如很多帧都没有标签,而且大多数的测试视频都只有一种或少数几种活动类型。在医疗健康领域,活动要密集的多,因此我们需要识别更多不同种类的活动。

为了解决这个问题,我们开发了基于 RNN 序列模型的网络,使用 multilevel loss 来预测同时发生的活动。我们在 MultiHUMOS 数据集上进行了计算机视觉基准测试,与 Vanilla LSTM 或者 Stream CNN 相比,我们的算法在多活动标记领域取得了领先的成果。

我们正试着在 InterMountain 医院的 ICU 里部署我们的模型,来观察病人的活动。我们选择从病人的四种活动开始,比如上床、下床等动作。知晓病人的活动水平,对医务人员提供更好的医疗服务至关重要。

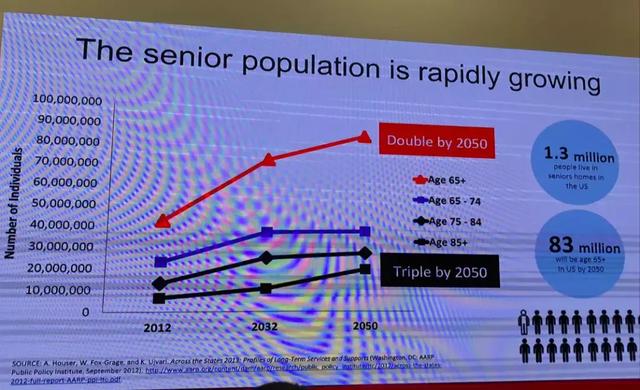

最后,我还想介绍下我们在减少训练数据量方面的工作,这在养老院的应用中非常有用。人口老龄化是世界性的问题,我们真的需要做一些事情来帮助老人们。

我们和很多老年病患交谈过,并确定了十几种和老年人健康息息相关的行为。我们希望最终使用计算机视觉系统来识别他们的行为,帮助患者和医生。举例来说,跌倒对老年人说是一个大问题,它甚至有可能夺走老人的生命。我们正在尝试解决跌倒检测的问题,但是在这个领域,我们不可能收集到大量的训练数据,因此我们的一个想法是使用自监督学习系统,比如我们去年发布在 CVPR 上的一项工作。另外,我们还尝试了迁移学习的想法。

3、医疗生态系统

最后,融入整个医疗生态系统也非常重要。为此,我们与斯坦福大学的其他小组展开合作,在为医院赋能时,我们不仅考虑智能传感器本身,还与病理学、放射学、医疗文献、图片等相结合。比如,我们和皮肤科医生一起研究烧伤患者的图像分割,又比如,我们也一直在寻找手术视频来识别手术中的活动。

总的来说,这是一个非常新兴的研究领域,它使用计算机视觉和机器学习算法来改善医疗保健服务,并帮助医生和护士观察病人活动,提高护理质量,从挽救更多的生命。从感知到人类活动识别到生态系统,以及建立大型合作关系,未来还有许多工作要做。

希望有人能够对这一领域的研究感兴趣。

谢谢大家!

转载自:AI科技大本营

- 案例

- 观点

- 医疗卫生

- CTO

- CIO

- CDO

- IT

- 大数据

- 机器人

- 云计算

推荐

-

中软国际凭借“防洪排涝及活水自流联控联调鸿蒙智慧水利解决方案”脱颖而出,荣获“2024年度中国企业数字化创新解决方案”殊荣。

-

平台以云计算、大数据、人工智能等数字化技术为依托,搭建起业务底座与数据底座

-

中国软件行业协会CIO分会作为中国软件行业协会直属分会,承担着推动软件和信息技术与实体经济融合发展的重要使命。分会一直致力于为CIO及信息技术专业人士提供一个交流平台,推动信息技术的创新和应用,加强行业内的信息共享与合作。

-

2024年十大央国企数字化标杆案例集重磅发布。

-

“2024中国企业数字化创新解决方案入选名单”正式揭晓,共有16家企业凭借其创新性和实用性等名列前茅。

-

2024中国企业数字化创新应用场景入选名单

我要评论